Breve Historia de las Redes Neuronales Artificiales (Articulo 1)

Para comprender donde nos encontramos actualmente, necesitamos observar el pasado y analizar cómo llegamos a este presente. Le expongo a continuación, una breve exposición sobre la historia de las Redes Neuronales Artificiales.

El cerebro humano es una maquina altamente poderosa y compleja capaz de procesar grandes cantidades de informaciones al mismo tiempo. Las unidades principales del cerebro son las neuronas, y es por medio de ellas que se transmite y procesa la información. Las tareas realizadas por el cerebro, intriga a los investigadores y científicos, como por ejemplo la capacidad del cerebro de reconocer un rostro familiar dentro de una multitud en apenas milésimas de segundos. En este sentido, algunos enigmas del funcionamiento del cerebro aún no han sido respondidas, manteniéndose hasta el día de hoy. El conocimiento sobre el funcionamiento del cerebro es que el mismo desarrolla sus propias reglas a través de la experiencia adquirida en situaciones vividas con anterioridad.

El desarrollo del cerebro humano ocurre principalmente en los dos primeros años de vida, sin embargo, continua en un periodo constante de desarrollo durante toda la vida. Inspirándose en este modelo, diversos investigadores trataron de simular el funcionamiento del cerebro, principalmente el proceso de aprendizaje por experiencia, a fin de crear sistemas inteligentes capaces de realizar tareas como clasificación, reconocimiento de patrones, procesamiento de imágenes, entre otras actividades. Como resultado de estas investigaciones surgió el modelo de neurona artificial y posteriormente un sistema de neuronas interconectados denominado red neuronal.

En 1943, el neurofisiologo Warren McCulloch y el matemático Walter Pitts, escribieron un artículo sobre como las neuronas pueden funcionar, para eso modelaron una red neuronal simple usando circuitos eléctricos. Warren McCulloch y Walter Pitts crearon un modelo computacional para redes neuronales basadas en matemática y algoritmos denominados Lógica de Umbral (threshold logic). Este modelo abrió el camino para la investigación de redes neuronales, dividida dos segmentos: uno enfocado en procesos biológicos en el cerebro y el otro en la aplicación de redes neuronales a la inteligencia artificial.

En 1949, Donald Hebb escribió su obra titulada The Organization of Behavior, la cual apunto al hecho de que las vías neuronales son fortalecidas cada vez que son utilizadas, un concepto fundamentalmente esencial para la manera en como los seres humanos aprenden. Argumentó que, si dos nervios se disparan al mismo tiempo, la conexión entre ellos es mejorada.

Posteriormente, a medida que los computadores se tornan más avanzados en la década de 1950, finalmente fue posible simular una hipotética red neuronal. El primer paso para eso fue hecho por Nathanial Rochester, quien pertenecía a los laboratorios de la IBM. Lamentablemente, su primer intento falló. Sin embargo, a lo largo de este tiempo los defensores de las “maquinas pensantes” continuaron la argumentación de sus investigaciones. En 1956, el Proyecto de Investigacion de verano de Dartmouth sobre Inteligencia Artificial (IA), proporcionó un impulso a la inteligencia artificial y a las redes neuronales. Uno de los resultados de este proyecto fue estimular una investigación en IA en la parte de procesamiento neuronal.

En los años siguientes, al proyecto Dartmouth, John von Neumann, sugirió imitar funciones simples de las neuronas utilizando relés telegráficos o tubos de vacío. Además, el neurobiólogo Frank Rosenblatt, comenzó a trabajar en el Perceptron. El estaba intrigado con el funcionamnieto de los ojos de las moscas, ya que gran parte del proceso realizado para decidir huir, es hecho en sus ojos. El Perceptron que resulto de esta investigación, realiza una suma ponderada de las entradas, substrae un límite y pasa uno de los dos valores posibles como resultado. Lamentablemente el Perceptron es limitado y fue comprobado como tal por Marvin Minsky y el libro de Seymour Papert del año 1969, Perceptrons.

En 1959, Bernard Widrow y Marcian Hoff, de Standford, desarrollaron modelos denominados “ADALINE” y “MADALINE” en una exibicion típica de Standford, los nombres provienen del uso de múltiples elementos ADAptive LINear. ADALINE, fue desarrolado para reconocer patrones binarios, de tal modo que, si por ejemplo estuviera leyendo bits de trasmisión de una línea telefónica, este podía predecir el próximo bit. MADALINE fue la primera red neuronal aplicada a un problema del mundo real, usando un filtro adaptativo que elimina los ecos de las líneas telefónicas. Estos sistemas, a pesar de ser tan antiguos como los sistemas de control de trafico aéreo, aún se encuentran uso comercial.

Lamentablemente los hechos anteriores, llevaron a las personas a exagerar el pontencial de las redes neuronales, particularmente a luz de la limitación en la electrónica, disponible para la época. Esta exageración excesiva se desarrolló en el mundo académico y técnico, infectando la literatura general de la época. Muchas promesas fueron hechas, sin embargo, los resultados fueron decepcionantes. De igual manera, muchos escritores comenzaron a reflexionar sobre el efecto tendrían las “maquinas pensantes” en la humanidad. La serie de los robots de Isaac Asimov, revelo los efectos sobre la moral y los valores del hombre cuando las maquinas tengan la capacidad de realizar todo el trabajo de la humanidad, entre otros escritos como la película HAL 9000 del año 2001.

Toda esa discusión sobre los efectos de la inteligencia artificial sobre la vida humana, aliada a los pocos progresos, impulsaron a voces respetadas, criticar las investigaciones de las redes neuronales. El resultado fue una reducción drástica de gran impacto, principalmente en el financiamiento de investigaciones. Este periodo de crecimiento atrofiado duro hasta 1981, siendo conocido como el Invierno de la Inteligencia Artificial (AI Winter).

Posteriormente, en 1982 varios eventos provocaron un renovado interés, John Hopfield investigador del Instituto de Tecnología de California (CALTECH) presentó un documento a la Academia Nacional de Ciencias cuyo abordaje no era simplemente modelar cerebros, su enfoque estaba centrado en crear dispositivos útiles. Con clareza y análisis matemático, el demostró como las redes neuronales funcionaban y lo que podían hacer. Sin embargo, el mayor recurso de Hopfield fue su carisma, ya que tenía mucha simpatía y esa cualidad colaboró mucho para ser escuchado.

En 1985, el Instituto Americano de Física, comenzó a realizar reuniones anuales – Redes neuronales para Computación. En 1987, la primera conferencia internacional sobre redes neuronales del Institute of Electrical an Electronic Enginner´s (IEEE), conquistó más de 1800 participantes.

En 1986, surgieron las redes backpropagation, las cuales generaron como resultado un aprendizaje lento por parte de las redes, ya que necesitaban muchas interacciones para aprender y generar un resultado más preciso.

Actualmente, las redes neuronales son utilizadas en varias aplicaciones. La idea fundamental detrás de la naturaleza de las redes neurales es que, si ellas funcionan en la naturaleza, deben ser capaz de funcionar en computadoras. El futuro de las redes neuronales, reside en el desarrollo de hardware. Las redes neuronales rápidas y eficientes dependen de hardware específicos para su eventual uso.

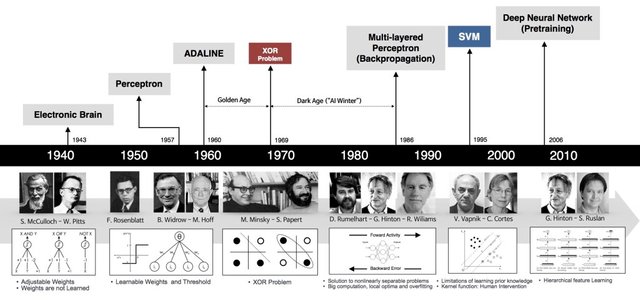

En el siguiente diagrama se esquematiza algunos marcos importantes en la evolución de las redes neuronales artificiales. El hecho es, que aun estamos escribiendo esta historia, cuya evolución esta ocurriendo en este momento a través del trabajo de millones de investigadores y profesionales de inteligencia artificial en todo el mundo.

En este sentido, se puede resumir los principales marcos en las investigaciones y evolución de las redes neuronales artificiales hasta llegar al Aprendizaje Profundo (Deep Learning):

1943: Warren McCulloch e Walter Pitt, crean un modelo computacional para redes neuronales basado en cálculos matemáticos y algoritmos denominados Logica de Umbral.

1958: Frank Rosenblatt, crea el Perceptron, un algoritmo para el reconocimiento de padrones basado en una red neuronal computacional de dos capas usando operaciones de adición y sustracción. También propuso capas adicionales con notaciones matemáticas, sin embargo, no fue realizado sino hasta 1975.

1980: Kunihiko Fukushima, propone el Neoconitron, una red neuronal de jerarquía, multicapa que fue utilizada para el reconocimiento de caligrafía y otros problemas de reconocimiento de padrones.

1989: Los científicos consigan crear algoritmos que usaban redes neuronales profundas, sin embargo los tiempos de entrenamiento para los sistemas fueron medidos en días, siendo impracticable para su uso en la vida real.

1992: Juyang Weng publica el Cresceptron, un método para realizar el reconocimiento de objetos 3D automáticamente a partir de escenas desordenadas.

Mediados del año 2000: el término “Aprendizaje Profundo” comienza a ganar popularidad, principalmente después de un artículo de Geoffrey Hinton y Ruslan Salakhutdinov, en el cual muestran como una red neuronal de varias capas podía ser pre entrenada con una capa a la vez.

2009: Ocurre el NIPS (Neural Information Processing Systems) Workshop sobre Aprendizaje Profundo para reconocimiento de voz, y se descubre que con un conjunto de datos suficientemente grande, las redes neuronales no necesitan de un pre entrenamiento y los valores relativos al error caen significativamente.

2012: Algoritmos de reconocimiento de padrones artificiales alcanzan un desempeño de nivel humano en determinadas tareas. El algoritmo de aprendizaje profundo de Google, es capaz de identificar gatos.

**2014: **Google compra la Startup de Inteligencia Artificial “DeepMind” de Reino Unido por 400 millones de euros.

2015: Facebook coloca en operación la tecnología de aprendizaje profundo “DeepFace” con el fin de identificar y etiquetar automáticamente usuarios de Facebook en las fotografías.

2016: El algoritmo de Google DeepMind, AlphaGo, mapea el arte del complejo juego de tablero Go y vence al campeón mundial de Go, Lee Sedol, en un torneo altamente divulgado en Seúl, capital de Corea del Sur.

2017: Adopción en masa del aprendizaje profundo en diversas aplicaciones así como también en investigaciones científicas y académicas. Todos los eventos de tecnología ligados al Data Science, IA y Big Data, apuntan al aprendizaje profundo (Deep Learning) como la principal tecnología para la creación de sistemas inteligentes.

2018: Continuaron los avances del aprendizaje profundo, revolucionando varios sectores de la sociedad, avizorando una fuerte demanda de profesionales especialistas en esta tecnología que no para de crecer.

La promesa del aprendizaje profundo no es que las computadoras comienzan a pensar como seres humanos, esto sería como pedirle a una manzana que sé que convierta en una naranja. Por el contrario, ha demostrado que dado un conjunto de datos suficientemente grande, procesadores rápidos y un algoritmo suficientemente sofisticado, las computadoras pueden comenzar a realizar tareas que hasta entonces solo podían ser realizadas por humanos, como el reconocimiento de imágenes y voz, crear obras de arte, segmentación y clasificación en imágenes satelitales, tomar decisiones por sí mismos, entre otras aplicaciones.

La evolución natural de las redes neuronales, son las redes neuronales profundas (Deep Learning), en este sentido les invito a continuar profundizando en estos conceptos en mi próximo articulo…!

Puedes seguirme también por Instagram…

https://www.instagram.com/machine.learning.rs/

Finalmente, si estas interesado en incrementar tu capital, obtener ingresos pasivos a través de la minería en la nube y pertenecer a un grupo WhatsApp en el cual tenemos:

• Apoyo las 24 horas por cualquiera de los miembros.

• Entrenamientos completamente gratis todas las semanas, donde nos enseñan las mejores estrategias para incrementar nuestros ingresos.

• Bonos, sorteos y mucho más.!

…te invito a que leas mi artículo en el siguiente link y tomes una de las mejores decisiones de tu vida…

https://steemit.com/spanish/@iars.geo/unete-al-equipo-de-aws-team-latino-network

Se trata de una de las empresas que está revolucionando la minería en la nube a nivel global, principalmente por su seriedad y compromiso con los inversores, ya que permite que cualquier persona visite sus granjas de minería y confirme por su propia cuenta que se trata de una empresa con infraestructura física y dirigentes reales, responsables y comprometidos…. Si te interesa no dudes en visitar mi artículo “Unete al equipo de AWS Team Latino Network”.

En caso de tener interés, contáctame para que asistas a una video conferencia antes de invertir y aclares todas las dudas que tengas!!!

Referencias Bibliográficas:

Christopher D. Manning. (2015). Computational Linguistics and Deep Learning Computational Linguistics, 41(4), 701–707.

F. Rosenblatt. The perceptron, a perceiving and recognizing automaton Project Para. Cornell Aeronautical Laboratory, 1957.

W. S. McCulloch and W. Pitts. A logical calculus of the ideas immanent in nervous activity. The bulletin of mathematical biophysics, 5(4):115–133, 1943.

The organization of behavior: A neuropsychological theory. D. O. Hebb. John Wiley And Sons, Inc., New York, 1949

B. Widrow et al. Adaptive ”Adaline” neuron using chemical ”memistors”. Number Technical Report 1553-2. Stanford Electron. Labs., Stanford, CA, October 1960.

“New Navy Device Learns By Doing”, New York Times, July 8, 1958.

Deep Learning Book. Data Science Academy.

Perceptrons. An Introduction to Computational Geometry. MARVIN MINSKY and SEYMOUR PAPERT. M.I.T. Press, Cambridge, Mass., 1969.

Minsky, M. (1952). A neural-analogue calculator based upon a probability model of reinforcement. Harvard University Pychological Laboratories internal report.

¡Felicitaciones!

Te participamos que puedes invertir en el PROYECTO ENTROPÍA mediante tu delegación de Steem Power y así comenzar a recibir ganancias de forma semanal transferidas automáticamente a tu monedero todos los lunes. Entra aquí para más información sobre cómo invertir en ENTROPÍA.

Apoya al trail de @Entropia y así podrás ganar recompensas de curación de forma automática. Entra aquí para más información sobre nuestro trail.

Puedes consultar el reporte diario de curación visitando @entropia.

Atentamente

El equipo de curación del PROYECTO ENTROPÍA

Congratulations @iars.geo! You have completed the following achievement on the Steem blockchain and have been rewarded with new badge(s) :

Click here to view your Board

If you no longer want to receive notifications, reply to this comment with the word

STOPDo not miss the last post from @steemitboard:

Hello @iars.geo! This is a friendly reminder that you have 3000 Partiko Points unclaimed in your Partiko account!

Partiko is a fast and beautiful mobile app for Steem, and it’s the most popular Steem mobile app out there! Download Partiko using the link below and login using SteemConnect to claim your 3000 Partiko points! You can easily convert them into Steem token!

https://partiko.app/referral/partiko

Congratulations @iars.geo! You received a personal award!

You can view your badges on your Steem Board and compare to others on the Steem Ranking

Vote for @Steemitboard as a witness to get one more award and increased upvotes!